insAIde #32 [Policy]: Habemus AI Act (almost)

Political agreement found, now awaiting the text and its formal approval

🍾 👡 What can we say, it was a rocky weekend, with an AI Act deal announced just before midnight on Friday, like an expected Cinderella.

⚠️ True, it was not the AI Act that was passed but the political agreement between the three European institutions (Parliament, Council and Commission) that took part in the trialogue and that, by reaching a record 36 hours of final negotiations (including 22 hours straight without sleep), closed the most difficult part of the legislative process. For this reason, all analyses and summaries, including this one, are based on what we have learned from the press (special mention for Luca Bertuzzi of Euractiv) and from the press releases of the institutions (go to the bottom for the various links).

📄 There are still a few details to be included in the text, which should be finalised this week, and will then have to go through the scrutiny of the lawyer-linguists. For formal approval, the regulation will have to go through the Council and Parliament's plenary session scheduled for February in Strasbourg.

🗓️ Once voted on and approved, the AI Act will have to be published in the European Official Journal and will become operational 2 years after publication, with a shorter enforcement period (6 months) for prohibited practices.

⏰ How did this trilogue go?

As can be imagined, at the end of the first 22 hours of negotiations the situation was rather critical. Particularly on fundamental rights, the Parliament saw a proposal arrive that was deemed inadmissible by civil society.

✌️ Fundamental rights

To protect rights, two important amendments were approved:

the possibility for individuals to take legal action, including through a class action, against AI systems in violation of the AI Act;

the requirement of a fundamental rights impact assessment (#FRIA) for those who market high-risk AI systems in the public sector or in the private sector offering essential services to the public (banks, insurance companies, schools, etc.).

The latter is particularly good news, the result of the work of civil society and academia. In addition to the letter signed two months ago by more than 150 internationally renowned academics, another one circulated just on Friday morning, in light of the risk to fundamental rights, as well as an appeal by civil society, signed by more than 55 organisations within a few hours.

🚔 📹 Use of AI by the police

The total ban wanted by Parliament and the EDPS - European Data Protection Supervisor on the use of real-time biometric recognition did not pass, as was to be expected. As reported by the organisation European Digital Rights, in fact, the final agreement provides for:

A ban on live public facial recognition, but with several exceptions for the search for certain victims, suspects, and for the prevention of terror attacks. Whilst these conditions are narrower than EU member states had pushed for, they nevertheless create a path to use these systems in dangerous, discriminatory and mass surveillance ways;

A limitation on post (retrospective) public facial recognition to the search for suspects of serious crime only, although the threshold for what constitutes a “serious” crime is currently undetermined;

A partial prohibition on predictive policing including predictions as to likelihood of committing a criminal offence on the basis of “personality traits or characteristics”, but not the majority of predictive policing systems;

A full ban on emotion recognition systems, but only in workplaces and educational settings. This illogically omits the most harmful uses of all: those in policing and border and migration contexts;

A purported ban on biometric categorisation systems, although whether or not this ban will be meaningful is still unclear;

Limited rights-based safeguards, including a mandatory fundamental rights impact assessment, and some level of public transparency as to which high-risk AI systems are deployed in Europe;

Very broad loopholes in the overall level of protection, including a wide discretion for AI developers to decide their systems are not ‘high-risk’, and also various exemptions to the rules for when law enforcement, migration and national security authorities deploy ‘high-risk’ AI. This is a major loss for public oversight of the most concerning AI systems.

🤖 Foundation models

The agreement on the Foundation's model chapter had already been found on Thursday, as reported by Euractiv. Having abandoned the idea of mere codes of conduct (as required by the common position of France, Germany and Italy) they will automatically be considered as 'systemic risk' if their computational power exceeds 10~25 FLOPS. The AI Office will have the task, supported by a board of technical experts, of identifying systems that fall into this category.

Providers of systems such as ChatGPT will have to provide their client companies with all the necessary documentation to be compliant. All these models will have transparency obligations regarding energy consumption (we sometimes forget that AI is not magic, but, on the contrary, consumes a lot of energy) and the use of databases and copyrighted content.

©️ Copyright

Speaking of copyright, there are some amendments and references to the 2019 European Copyright Directive. In particular, it says that General Purpose AI providers must:

put in place a policy to respect Union copyright law in particular to identify and respect, including through state of the art technologies where applicable, the reservations of rights expressed pursuant to Article 4(3) of Directive (EU) 2019/790;

as well as

draw up and make publicly available a sufficiently detailed summary about the content used for training of the general-purpose AI model, according to a template provided by the AI Office;

The recital clarifies that

summary should be comprehensive in its scope instead of technically detailed, for example by listing the main data collections or sets that went into training the model, such as large private or public databases or data archives, and by providing a narrative explanation about other data sources used.

Enzo Mazza , head of FIMI - Federazione industria musicale italiana , was also satisfied with this outcome.

As pointed out by Paul Keller in his analysis, the explicit reference to Article 4 of the copyright directive, which provides that data extraction for research is lawful as long as there is no express objection by the rightsholder, begs the question of whether or not, at the time of its publication, the legislators had envisaged this type of database use, and thus Article 4 could be used as a legal basis for data extraction for AI training purposes.

After all, the copyright issue, even in the presence of the directive, had not been expressly addressed and many rights holders wanted to be reassured, given the tendency of these systems to scrap online content, a circumstance that is also under scrutiny by the Autorità Garante per la protezione dei dati personali for the what concerns the processing of personal data.

🧑⚖️ Governance

From what we know from internal sources, the AI Office will be created within the European Commission and will be in charge of the enforcement and supervision of ChatGPT-type models. The AI Office will act as the secretariat of the board formed by the national authorities, will have its own dedicated budget and will be functionally independent. Very interesting to mention is the presence, besides the scientific one, of a civil society advisory forum, which will help the board to assess the overall impact on fundamental rights of AI systems.

On the subject of national authorities, the European Parliament had asked for the Supervisory Authority to be independent, as, in Italy, the Garante privacy, AGCOM, AGCM are, but it seems that this possibility has faded. The problem with the lack of independence requirement is that an Authority that depends on the government would be more easily subject to top management changes at every political change, not guaranteeing the continuity that companies would also need. This would seem to dispel the idea that the Italian DPA could be the regulatory authority, considered by professionals in the sector as the ideal candidate to also regulate AI, given its long experience in the field of data and new technologies. But the last word is never said, since each Member State could still decide for an independent Authority. Instead, the Authority that will have to supervise the use of AI by law enforcement agencies will be independent.

💸 Sanctions

Along the same lines as the last European regulations, the sanctions provide for up to:

EUR 35 million, or 7% of global turnover, for violations of prohibited AI applications,

EUR 15 million, or 3%, for violations of AI Act obligations

EUR 7.5 million, or 1.5%, for providing incorrect information.

However, the agreement provides for more proportionate ceilings for administrative penalties for SMEs and start-ups in case of violations.

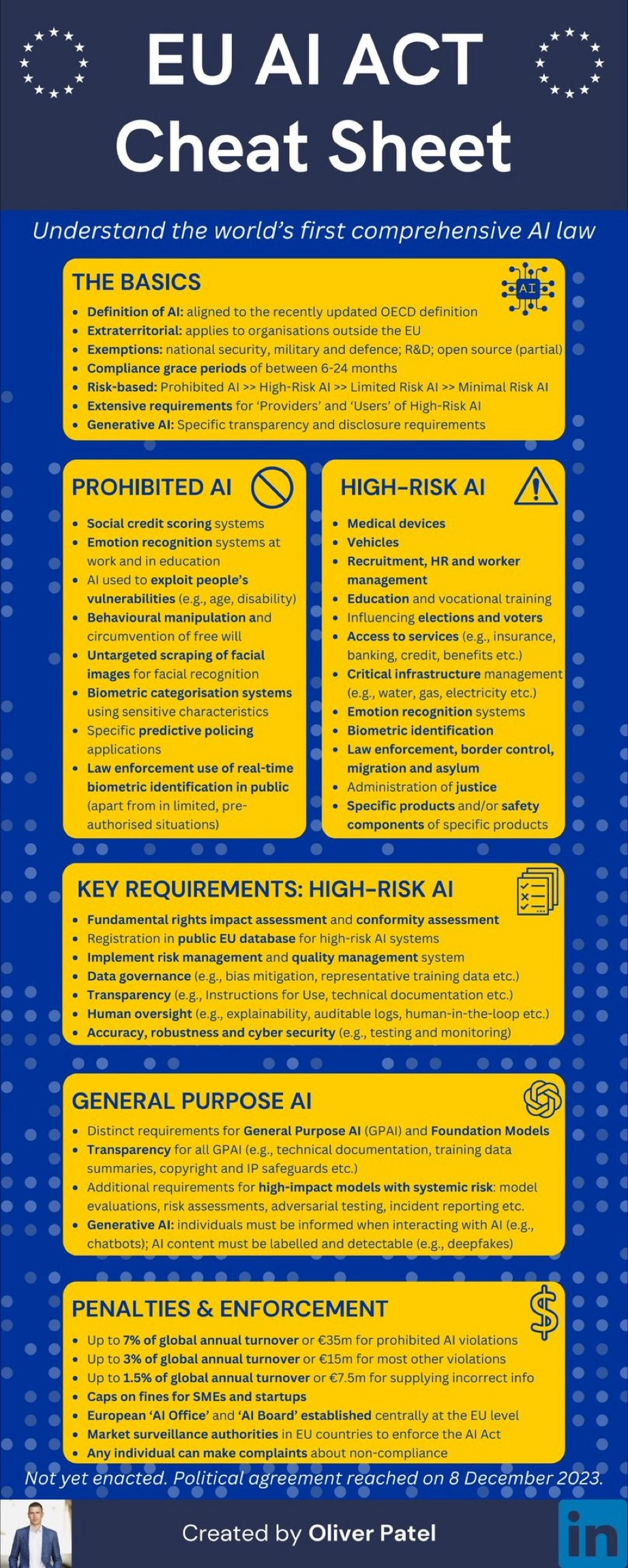

BONUS: A nice infographic by Oliver Patel, CIPP/E .

Some useful links collected by our Gabriele Franco:

📌 Press release of the European Parliament

📌 Press release of the Council of the European Union

📌 Press release of the European Commission

📌 Press conference of the trialogue

🇮🇹 Versione italiana

🍾 👡 Che dire, è stato un fine settimana spumeggiante, con un AI Act annunciato poco prima della mezzanotte di venerdì, come una attesa Cenerentola.

⚠️ Prima che gli animi dei più integerrimi si scaldino, NO, non è stato approvato l’AI Act ma l’accordo politico tra le tre istituzioni europee (Parlamento, Consiglio e Commissione) che hanno preso parte al trilogo e che, raggiungendo il record di 36 ore di negoziato finale (di cui 22 ore di fila senza dormire), hanno chiuso la parte più difficile del processo legislativo. Per questo motivo, ogni analisi e riassunto, incluso questo, si basano su quanto appreso dalla stampa (special mention per Luca Bertuzzi di Euractiv) e dai comunicati delle istituzioni (andare in fondo per i vari link).

📄 Mancano ancora alcuni dettagli da inserire nel testo, che dovrebbe essere finalizzato questa settimana, che dovrà poi passare al vaglio dei giuristi linguisti. Per la formale approvazione il regolamento dovrà ripassare dal Consiglio e dalla Plenaria del Parlamento prevista per febbraio a Strasburgo.

🗓️ Una volta votato e approvato, l’AI Act dovrà essere pubblicato in Gazzetta Ufficiale Europea e diventerà operativo dopo 2 anni dalla pubblicazione, con tempi di applicazione più brevi (6 mesi) per le pratiche proibite.

⏰ Com’è andato questo trilogo?

Come immaginabile, alla fine delle prime 22 ore di fila di negoziazione la situazione era piuttosto critica. In particolare sui diritti fondamentali il Parlamento si è visto arrivare una proposta ritenuta dalla società civile irricevibile, come abbiamo riportato su Repubblica venerdì mattina.

✌️ Diritti fondamentali

A tutela dei diritti sono stati approvati due emendamenti importanti:

la possibilità per le persone di fare ricorso all’autorità giudiziaria, anche mediante una class action, contro i sistemi di AI diffusi in violazione dell’AI Act;

l’obbligo di una valutazione di impatto sui diritti fondamentali per chi mette sul mercato sistemi AI ad alto rischio nel settore pubblico o nel settore privato che offre servizi essenziali al pubblico (banche, assicurazioni, scuole etc).

Quest’ultima è in particolare un’ottima notizia, frutto del lavoro della società civile e del mondo accademico. Oltre alla lettera firmata due mesi fa da oltre 150 accademici di fama internazionale (ne abbiamo parlato qui), un’altra è circolata proprio venerdì mattina, alla luce del rischio che c’era per i diritti fondamentali, così come un appello della società civile, firmato, in poche ore, da oltre 55 organizzazioni.

🚔 📹 Uso dell’AI da parte della polizia

Non è passato, come era prevedibile, il ban totale voluto dal Parlamento e dall’EDPS per l’uso del riconoscimento biometrico in tempo reale. Come riportato dall’organizzazione EDRi, infatti, l’accordo fiinale prevede:

Il divieto di riconoscimento facciale in pubblico, ma con diverse eccezioni per la ricerca di alcune vittime, sospetti e per la prevenzione di attacchi terroristici. Sebbene queste condizioni siano più restrittive di quanto richiesto dagli Stati membri dell'UE, creano comunque un percorso per l'utilizzo di questi sistemi in modi pericolosi, discriminatori e di sorveglianza di massa;

una limitazione del riconoscimento facciale pubblico successivo (retroattivo) alla ricerca di sospetti di reati gravi, anche se la soglia di ciò che costituisce un reato "grave" è attualmente indeterminata;

Un divieto parziale sulla polizia predittiva, comprese le previsioni sulla probabilità di commettere un reato sulla base di "tratti o caratteristiche della personalità", ma non sulla maggior parte dei sistemi di polizia predittiva;

Un divieto totale sui sistemi di riconoscimento delle emozioni, ma solo nei luoghi di lavoro e negli ambienti educativi. Questo omette illogicamente gli usi più dannosi di tutti: quelli in contesti di polizia, frontiera e migrazione;

Un presunto divieto sui sistemi di categorizzazione biometrica, anche se non è ancora chiaro se questo divieto sarà significativo o meno;

Ampie lacune nel livello complessivo di protezione, tra cui un'ampia discrezionalità per gli sviluppatori di IA nel decidere che i loro sistemi non sono "ad alto rischio", e anche varie esenzioni alle regole per quando le forze dell'ordine, le autorità per la migrazione e la sicurezza nazionale impiegano IA "ad alto rischio". Si tratta di una grave perdita per la supervisione pubblica dei sistemi di IA più preoccupanti.

🤖 Foundation model

La quadra al capitolo dei Foundation model invece era stata già trovata giovedì, come riferito da Euractiv. Abbandonata l’idea dei meri codici di condotta (come richiesto dalla posizione comune di Francia, Germania e Italia che aveva scombussolato i piani) essi saranno considerati automaticamente come “systemic risk” se la loro potenza computazionale supererà i 10~25 FLOPS. L’AI Office avrà il compito, affiancato da un board di esperti tecnici, di individuare i sistemi che rientrano nella categoria.

I provider di sistemi come ChatGPT dovranno fornire alle aziende clienti tutta la documentazione necessaria per essere compliant.

Tutti questi modelli avranno obblighi di trasparenza relativi al consumo energetico (a volte scordiamo che l’AI non è magica, ma, anzi, consuma moltissima energia, necessaria per la capacità di calcolo) e all’uso di database e informazioni coperte da copyright.

©️ Copyright

A proposito di copyright, sono stati inseriti alcuni emendamenti e rimandi proprio alla direttiva europea sul copyright del 2019. In particolare si dice che i fornitori di General Purpose AI devono:

mettere in atto una politica di rispetto del diritto d'autore dell'Unione, in particolare per individuare e rispettare, anche attraverso tecnologie all'avanguardia, se del caso, le riserve di diritti espresse ai sensi dell'articolo 4, paragrafo 3, della direttiva (UE) 2019/790;

nonché

redigere e rendere disponibile al pubblico una sintesi sufficientemente dettagliata dei contenuti utilizzati per l'addestramento del modello di IA per scopi generali, secondo un modello fornito dall'AI Office.

Il considerando chiarisce che

il riepilogo dovrebbe essere completo nella sua portata anziché tecnicamente dettagliato, ad esempio elencando le principali raccolte o set di dati che sono stati utilizzati per l'addestramento del modello, come grandi database privati o pubblici o archivi di dati, e fornendo una spiegazione narrativa su altre fonti di dati utilizzate.

Di questo esito si è detto soddisfatto anche Enzo Mazza, a capo di FIMI, la federazione industria musicale italiana.

Come evidenziato da Paul Keller, il riferimento esplicito all’Articolo 4 della direttiva copyright, che prevede che l’estrazione dei dati a scopo di training è lecita purché non vi sia l’obiezione espressa dell’avente diritto, pone fina alla questione se, ai tempi della sua pubblicazione, il legislatore avesse previsto o meno questo tipo di utilizzo dei database, e quindi si potesse usare l’Articolo 4 come base giuridica per l’estrazione di dati per allenare le AI.

Del resto, il nodo del copyright, pur in presenza della direttiva, non era stato affrontato espressamente e molti detentori di diritti volevano essere rassicurati, vista la tendenza a fare scraping dei contenuti online da parte di questi sistemi, circostanza che è anche al vaglio del Garante Privacy per il profilo che riguarda i dati personali.

🧑⚖️ Governance

Da quanto sappiamo da fonti interne, l’AI Office sarà creato in seno alla Commissione europea e si occuperà dell’enforcement e della supervisione dei modelli tipo ChatGPT. L’AI Office farà il segretariato del board formato dalle autorità nazionali, avrà un suo bilancio dedicato e sarà funzionalmente indipendente. Molto interessante da segnalare è la presenza, oltre a quello scientifico, di un advisory forum della società civile, che aiuterà il board a valutare l’impatto complessivo sui diritti fondamentali dei sistemi di AI.

A proposito di Autorità nazionale, il Parlamento europeo aveva chiesto che l'Autorità di vigilanza fosse indipendente, come lo sono Garante privacy, AGCOM, AGCM, ma pare che questa possibilità sia sfumata. Il problema del mancato requisito dell’indipendenza è che un'Autorità che dipenda dal governo sarebbe più facilmente soggetta ai cambi dei vertici ad ogni cambio politico, non garantendo quella continuità di cui anche le aziende avrebbero bisogno. Ciò sembrerebbe far sfumare l’idea che possa essere il Garante privacy l’Autorità regolatrice, considerato dai professionisti del settore il candidato ideale a regolare anche l'AI in Italia, vista la lunga esperienza nel settore dei dati e delle nuove tecnologie. Ma non è mai detta l’ultima parola visto che ciascun Stato membro potrebbe decidere comunque per una Autorità indipendente. Sarà invece indipendente l’Autorità che dovrà vigilare sull’uso dell’AI da parte delle forze dell’ordine.

💸 Sanzioni

Sullo stesso impianto degli ultimi regolamenti europei, le sanzioni prevedono fino a:

35 milioni di euro, o il 7% del fatturato globale, per le violazioni delle applicazioni AI vietate,

15 milioni di euro, o il 3%, per le violazioni degli obblighi previsti dall’AI Act

7,5 milioni di euro, o l'1,5%, per la fornitura di informazioni non corrette.

Tuttavia, l'accordo prevede massimali più proporzionati per le sanzioni amministrative per le PMI e le start-up in caso di violazione.

BONUS: Un bel riassunto in formato infografica, realizzato da Oliver Patel.

Qualche link utile raccolto dal nostro Gabriele Franco:

📌 Comunicato stampa dell'European Parliament

📌 Comunicato stampa del Council of the European Union

📌 Comunicato stampa dell'European Commission

📌 Conferenza stampa del trilogo

🚨 Eventi e rassegna stampa del nostro team

🗞️ Rocco Panetta ha rilasciato un primo commento a caldo dopo l’approvazione dell’accordo politico sull’AI Act su Repubblica e Agenda Digitale. Questi seguono l’articolo su Repubblica, a firma sua e di Vincenzo Tiani, in cui si sono espresse le preoccupazioni per un testo che rischiava di lasciare la porta (troppo) aperta alla sorveglianza di massa.

🗓️ Il 13 dicembre alle 14:30, Vincenzo Tiani sarà ospite della rassegna Caffè Artificiali per parlare di AI e trasparenza. Tutte le info per registrarsi e seguire l’evento online qui.

🗓️ Il 15 dicembre, alle 17:00, Rocco Panetta parteciperà ai lavori del tavolo “Internet, IA e Privacy“ alla LUISS di Roma, in occasione della III edizione del convegno di tre giorni, a cura dei proff. Francesco Di Ciommo e Giuseppe Cassano.

⏰ Da parte nostra è tutto, ci vediamo insAIde, martedì prossimo, alle 08:00.

Rocco Panetta, Federico Sartore, Vincenzo Tiani, Davide Montanaro, Gabriele Franco